关于K聚类,我曾经在一篇博客中提到过,这里简单的做个回顾。

KMeans的步骤以及其他的聚类算法

K-均值是因为它可以发现k个不同的簇,且每个簇的中心采用簇中所含值的均值计算

其他聚类算法:二分K-均值

讲解一下步骤,其实就是说明一下伪代码

随机选择k个点作为起始质心

当任意一个点的簇分配结果发生改变时

对数据集中的每个数据点

对每个质心

计算质心与数据点之间的距离

将数据分配到距其最近的簇

对每一个簇,计算簇中所有点的均值并将均值作为质心OpenCV中使用cv2.kmeans()对数据进行分类

理解函数的参数

输入参数:cv2.kmeans(data,K, bestLabels,criteria,attempt,flags)

1. data:应该是np.float32类型的数据,每个特征应该放在一列。

2. K:聚类的最终数目

3. criteria:终止迭代的条件。当条件满足,算法的迭代终止。它应该是一个含有3个成员的元组,它们是(type,max_iter, epsilon):

type终止的类型:有如下三种选择:

- cv2.TERM_CRITERIA_EPS 只有精确度epslion满足时停止迭代

- cv2.TERM_CRITERIA_MAX_ITER 当迭代次数超过阈值时停止迭代

– cv2.TERM_CRITERIA_EPS + cv2.TERM_CRITERIA_MAX_ITER 上面的任何一个条件满足时停止迭代

max_iter:最大迭代次数

epsilon:精确度阈值

4. attempts:使用不同的起始标记来执行算法的次数。算法会返回紧密度最好的标记。紧密度也会作为输出被返回

5. flags:用来设置如何选择起始中心。通常我们有两个选择:cv2.KMEANS_PP_CENTERS和 cv2.KMEANS_RANDOM_CENTERS。

输出参数:

1. compactness:紧密度返回每个点到相应中心的距离的平方和

2. labels:标志数组,每个成员被标记为0,1等

3. centers:有聚类的中心组成的数组

仅有一个特征的数据

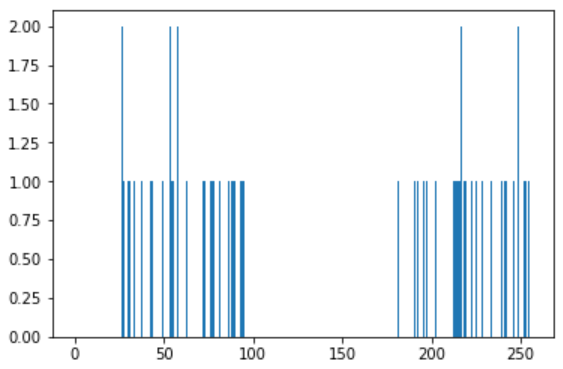

假设我们有一组数据,每个数据只有一个特征。例如前面的T恤问题,我们只用身高来决定T恤的大小。我们来产生一些随机数据,并使用Matplotlib

# 随机在25~100之间产生25个值

x = np.random.randint(25,100,25)

y = np.random.randint(175,255,25)

z = np.hstack((x,y))

z = z.reshape((50,1))

z = np.float32(z)

plt.hist(z,256,[0,256]),plt.show()

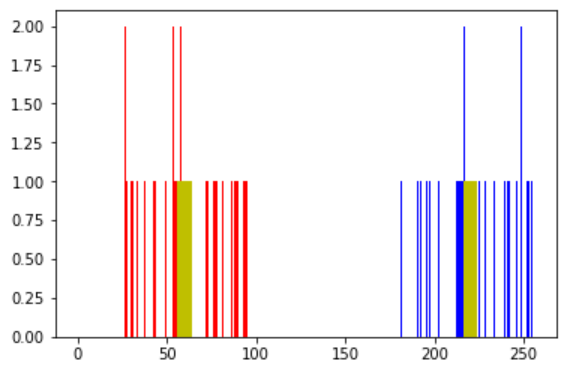

我们使用KMeans函数。先设置好终止条件。10次迭代或者精确度epsilon=1.0

# Define criteria = ( type, max_iter = 10 , epsilon = 1.0 ) criteria = (cv2.TERM_CRITERIA_EPS + cv2.TERM_CRITERIA_MAX_ITER, 10, 1.0) # Set flags (Just to avoid line break in the code) flags = cv2.KMEANS_RANDOM_CENTERS # Apply KMeans compactness,labels,centers = cv2.kmeans(z,2,None,criteria,10,flags)

把数据分成两组

A = z[labels==0] B = z[labels==1]

现在将 A 组数用红色表示,将 B 组数据用蓝色表示,重心用黄色表示。

# Now plot 'A' in red, 'B' in blue, 'centers' in yellow plt.hist(A,256,[0,256],color = 'r') plt.hist(B,256,[0,256],color = 'b') plt.hist(centers,32,[0,256],color = 'y') plt.show()

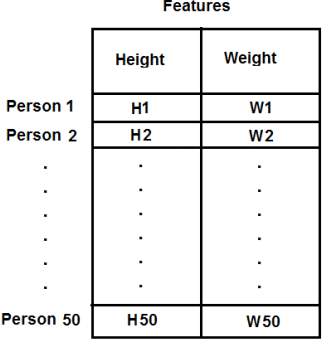

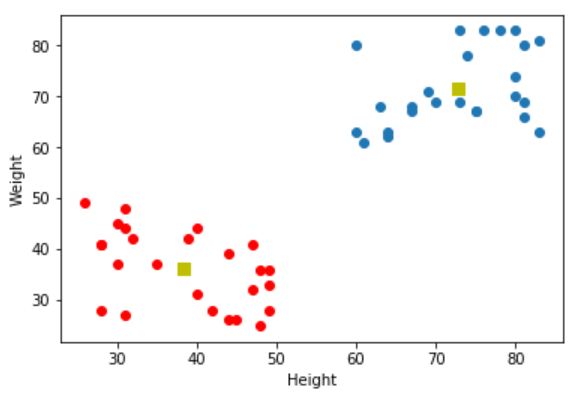

含有多个特征的数据

T恤我们只考虑了身高,现在将体重也考虑进去,也就是两个特征。在本例中我们的测试数据是50x2的向量,其中包含50个人的身高和体重。第一列对应身高,第二列对应体重。如下图所示:

import numpy as np import cv2 from matplotlib import pyplot as plt X = np.random.randint(25,50,(25,2)) Y = np.random.randint(60,85,(25,2)) Z = np.vstack((X,Y)) # convert to np.float32 Z = np.float32(Z) # define criteria and apply kmeans() # 迭代次数为10次,精确度为1.0 criteria = (cv2.TERM_CRITERIA_EPS + cv2.TERM_CRITERIA_MAX_ITER, 10, 1.0) ret,label,center=cv2.kmeans(Z,2,None,criteria,10,cv2.KMEANS_RANDOM_CENTERS) # Now separate the data, Note the flatten() A = Z[label.ravel()==0] B = Z[label.ravel()==1] # Plot the data plt.scatter(A[:,0],A[:,1]) plt.scatter(B[:,0],B[:,1],c = 'r') plt.scatter(center[:,0],center[:,1],s = 80,c = 'y', marker = 's') plt.xlabel('Height'),plt.ylabel('Weight') plt.show()

颜色量化

颜色量化就是减少图片中颜色数目的一个过程,其原因是为了减少内存消耗。现在有3个特征:R,G,B,所以我们需要把图片数据变形成Mx3(M是图片中像素点的数目)的向量。聚类完成后,我们用聚类中心值替换与其同簇的像素值,这样结果图片就只含指定数目的颜色了。

分别取K=2、4、8

import numpy as np import cv2 img = cv2.imread('home.jpg') Z = img.reshape((-1,3)) # convert to np.float32 Z = np.float32(Z) # define criteria, number of clusters(K) and apply kmeans() criteria = (cv2.TERM_CRITERIA_EPS + cv2.TERM_CRITERIA_MAX_ITER, 10, 1.0) K = 2 ret,label,center=cv2.kmeans(Z,K,None,criteria,10,cv2.KMEANS_RANDOM_CENTERS) # Now convert back into uint8, and make original image center = np.uint8(center) res = center[label.flatten()] res2 = res.reshape((img.shape)) cv2.imshow('K=2',res2) cv2.imwrite('K=2.png', res2) cv2.waitKey(0) cv2.destroyAllWindows()