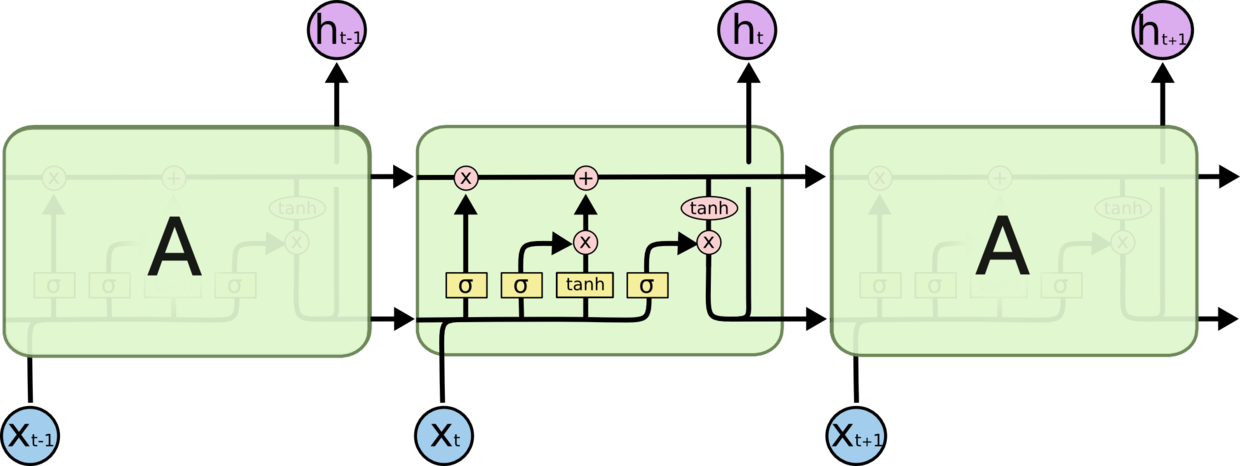

LSTM公式推导~~

H作为一个时序状态的输出

ft = sigmoid(Wi*[Ht-1,Xt]+bi)

ft作为Ct-1的信号控制量,传下来的信号的多少0~1之间

Ct = ft*Ct-1 + sigmoid(wj*[Ht-1,Xt]+bj)*tanh(Wg*[Ht-1,Xt]+bg)

^Ct = sigmoid(wj*[Ht-1, Xt]+bj)*tanh(Wg*[Ht-1, Xt]+bg)

Ht = tanh(Wr*(ft*Ct-1+sigmoid(Wj*[Ht-1,Xt]+bj)*tanh(Wg*[Ht-1,Xt]+bg))+br)*sigmoid(We*[Ht-1,Xt]+be)

几个部分:1,产生候选信号 ~~>

2 ,筛选的信号比率sigmoid层,sgmoid(W*[Ht-1,Xt]+B)

筛选Ct-1记住的比例-----》+ 本时序信息筛选比率(fr) * 本层生成记忆东西 tanh(W*[Ht-1,Xt]+b)

Ct --->本层记忆信号 = 上一层*筛选率+本层生成*筛选率

Ht = 筛选率*tanh(Ct)