Spiders

Spider类定义了如何爬取某个网站。包括了爬取的动作(例如:是否跟进链接)以及如何从网页的内容中提取结构化数据(爬取item)。简而言之,Spider就是你定义爬取的动作及分析某个网页(或者是有些网页)的地方。

对spider来说,爬取的循环类似如下:

以初始的URL(start_urls或者start_requests())初始化Request,并设置回调函数。当该request下载完毕并返回时,将生成response,并作为参数传给该回调函数。spider中初始的request是通过调用start_requests() 来获取。start_requests() 读取start_urls中的URL,并以parse为回调函数生成 Request。

在回调函数内分析返回的(网页)内容,返回 Item 对象、dict、 Request 或者一个包括三者的可迭代容器。 返回的Request对象之后会经过Scrapy处理,下载相应的内容,并调用设置的callback函数(函数可相同)。

在回调函数内,您可以使用 选择器(Selectors) (您也可以使用BeautifulSoup, lxml 或者您想用的任何解析器) 来分析网页内容,并根据分析的数据生成item。

最后,由spider返回的item将被存到数据库(由某些 Item Pipeline 处理)或使用 Feed exports 存入到文件中。

scrapy为我们提供了如下的一些spider类来应对不同的爬取需求。

- scrapy.spiders.Spider

Spider是最简单的spider。每个其他的spider必须继承自该类(包括Scrapy自带其他spider以及你自己编写的spider)。Spider仅仅提供了 start_requests()的默认实现,读取并请求spider属性中的 start_urls, 并根据返回的结果(resulting responses)调用spider的 parse 方法。 - scrapy.spiders.CrawlSpider

爬取一般网站常用的spider。其定义了一些规则(rule)来提供跟进link的方便的机制。比如一些网站的url通常是这样的http://www.example.com/123.html,http://www.example.com/456.html博客类的网站通常会这样,我们可以直接使用这个类提供的Rule来进行网址匹配。当然我们也可以实现自己的spider。 - scrapy.spiders.XMLFeedSpider

XMLFeedSpider被设计用于通过迭代各个节点来分析XML源(XML feed)。 迭代器可以从 iternodes , xml , html 选择。 鉴于 xml 以及 html 迭代器需要先读取所有DOM再分析而引起的性能问题, 一般还是推荐使用 iternodes 。 不过使用 html 作为迭代器能有效应对错误的XML。 - scrapy.spiders.CSVFeedSpider

该spider除了其按行遍历而不是节点之外其他和XMLFeedSpider十分类似。 而其在每次迭代时调用的是 parse_row() 。 - scrapy.spiders.SitemapSpider

SitemapSpider使您爬取网站时可以通过 Sitemaps 来发现爬取的URL。其支持嵌套的sitemap,并能从 robots.txt 中获取sitemap的url。

这里我们着重学习前面两种,也是非常常用的两种。

scrapy.Spider

class scrapy.spiders.Spider

在这之前,我们写的爬虫中,其实已经用到了这个类,我们自定义的spider就是继承自该类,现在我们详细的了解该类的一些常用的属性和方法,具体的详尽信息可以参照官方文档。

- name

定义spider名字的字符串(string)。spider的名字定义了Scrapy如何定位(并初始化)spider,所以其必须是唯一的。name是spider最重要的属性,而且必须。

一般就是以网站的URL去掉前后缀来命名,如www.baidu.com我们的name就可以为baidu,简单明了。 - allowed_domains

可选。包含了spider允许爬取的域名(domain)列表(list)。 当 OffsiteMiddleware 启用时, 域名不在列表中的URL不会被跟进。 - start_urls

URL列表。当没有制定特定的URL时,spider将从该列表中开始进行爬取。 因此,第一个被获取到的页面的URL将是该列表之一。 后续的URL将会从获取到的数据中提取。 start_requests()

该方法必须返回一个可迭代对象(iterable)。该对象包含了spider用于爬取的第一个Request。该方法仅仅会被Scrapy调用一次,可以将其实现为生成器。

该方法的默认实现是使用 start_urls 的url生成Request。我们可以重写该方法来实现定制。比如我们想要一开始就实现一个post请求,通过默认的方法可定是不行的。因此我们重写该方法如下。class MySpider(scrapy.Spider): name = 'myname' def start_requests(self): return [scrapy.FormRequest("http://www.example.com/login", formdata={'user': 'john', 'pass': 'secret'}, callback=self.logged_in)] def logged_in(self, response): print('登陆成功') pass- parse(response)

当response没有指定回调函数时,该方法是Scrapy处理下载的response的默认方法。parse 负责处理response并返回处理的数据以及(/或)跟进的URL。

该方法及其他的Request回调函数必须返回一个包含 Request、dict 或 Item 的可迭代的对象。简单的来说,所谓的回调函数,其实就是告诉spider,在拿到了网站的response以后,交给谁来进行处理后面的页面的解析工作。 closed(reason)

当spider关闭时,该函数被调用。

常用的Spider的属性和方法就是这些,下面是一个综合的例子。

import scrapy from myproject.items import MyItem class MySpider(scrapy.Spider): name = 'cnblog' allowed_domains = ['cnblogs.com'] start_urls = ['http://www.cnblogs.com.com/123.html', 'http://www.cnblogs.com.com/234.html', 'http://www.cnblogs.com.com/345.html' ] def start_requests(self): for url in self.start_urls: yield scrapy.Request(url=url, callback=self.parse) def parse(self, response): for h3 in response.xpath('//h3').extract(): item = MyItem() item['title'] = h3 yield item for url in response.xpath('//a/@href').extract(): yield scrapy.Request(url, callback=self.parse)

请注意看,我们可以在start_requests()方法里面请求多个URL,这会形成一个请求队列,并且可以使用同样的解析方法对response进行解析,parse()方法的返回结果可以也仅可以有两种,官方文档上面说明是三种,其实item和字典我们算做一种,两种返回值的例子都包含在上面,一种是item或者说是字典,scrapy会将item交给item pipeline去进行后续的处理,包括数据的清洗,存储;另一种是Request,此时scrapy会将这个请求放入调度器请求队列,后续会对其进行请求解析。scrapy的引擎也是通过返回的两种类型来区别是交给pipeline还是scheduler进行后续的处理。

scrapy.CrawlSpider

class scrapy.spiders.CrawlSpider

在爬取一些特殊类型的网站时,比如一些博客类网站,其网页的链接都会有一些特殊的形式,简单的例子,博客园的博客内容,http://www.cnblogs.com/cnkai/p/7397421.html,http://www.cnblogs.com/cnkai/p/7396835.html比如我们想爬取我的博客内容,会发现,除了最后的几个数字不同,其他的内容是相同的,因此,我们就可以通过这个类来进行自动抓取相似的链接,而无需我们自己定义。

CrawlSpider类定义了如下的属性和方法。

- rules

一个包含一个(或多个) Rule 对象的集合(list)。 每个 Rule 对爬取网站的动作定义了特定表现。 Rule对象在下边会介绍。 如果多个rule匹配了相同的链接,则根据他们在本属性中被定义的顺序,第一个会被使用。 - parse_start_url(response)

当start_url的请求返回时,该方法被调用。 该方法分析最初的返回值并必须返回一个 Item 对象或者 一个 Request 对象或者 一个可迭代的包含二者对象。

CrawlSpider需要配合scrapy.spiders.Rule类来实现定义规则

下面介绍scrapy.spiders.Rule类

class scrapy.spiders.Rule(link_extractor, callback=None, cb_kwargs=None, follow=None, process_links=None, process_request=None)

link_extractor

这是一个 Link Extractor 对象。 其定义了如何从爬取到的页面提取链接。- callback

这是一个callable或string(该spider中同名的函数将会被调用)。 从link_extractor中每获取到链接时将会调用该函数。该回调函数接受一个response作为其第一个参数, 并返回一个包含 Item 以及(或) Request 对象(或者这两者的子类)的列表(list) - cb_kwargs

包含传递给回调函数的参数(keyword argument)的字典。 - follow

是一个布尔(boolean)值,指定了根据该规则从response提取的链接是否需要跟进。 如果 callback 为None, follow 默认设置为 True ,否则默认为 False 。 - process_links

是一个callable或string(该spider中同名的函数将会被调用)。 从link_extractor中获取到链接列表时将会调用该函数。该方法主要用来过滤。 process_request

是一个callable或string(该spider中同名的函数将会被调用)。 该规则提取到每个request时都会调用该函数。该函数必须返回一个request或者None。 (用来过滤request)

下面是一个详细的样例

import scrapy

from scrapy.spiders import CrawlSpider, Rule

from scrapy.linkextractors import LinkExtractor

class MySpider(CrawlSpider):

name = 'cnblog'

allowed_domains = []

start_urls = ['http://www.cnblogs.com']

rules = (

Rule(LinkExtractor(allow=('http://www.cnblogs.com/w+/p/d+.html', )), callback='parse_item', follow=True),

)

def parse_item(self, response):

print(response.url)简单的解释:

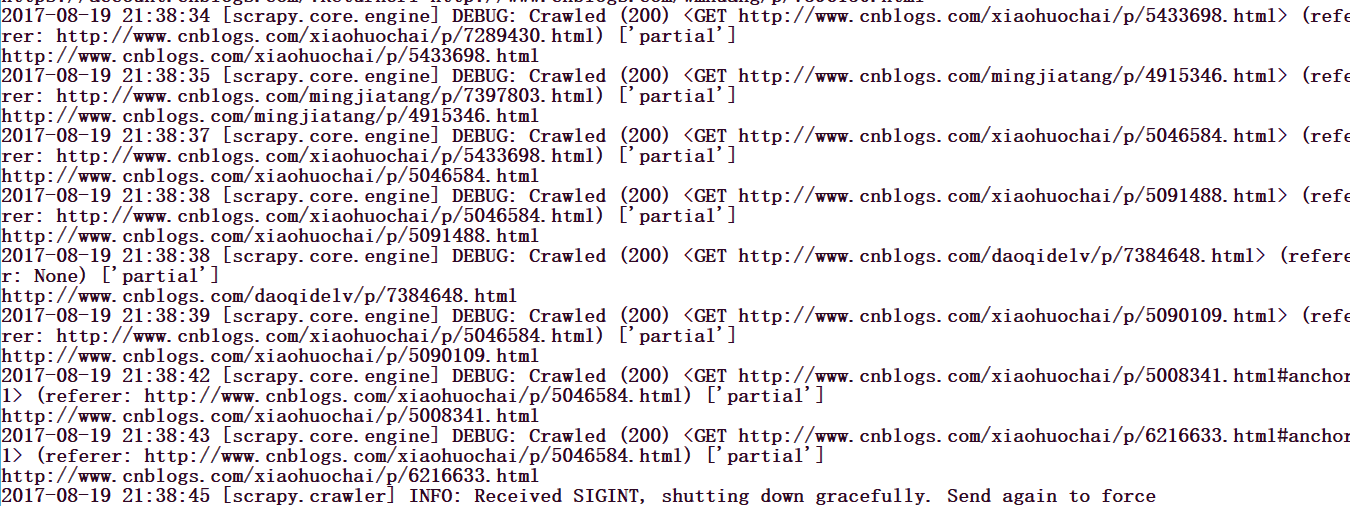

rules()中的allow=('http://www.cnblogs.com/w+/p/d+.html', )表示我们需要匹配的格式,其中包含了正则表达式,w+表示匹配任意的字母数字下划线汉字至少一次,d+表示匹配任意的数字至少一次,callback设置回调函数,follow=True表示跟进response里面的链接,最终的结果就是提取出所有的满足要求的连接,并打印出来,这个数量会很庞大,如果你的爬虫没有被ban的话,这里我简单的运行一下,可以看到下面的链接被打印了出来。且这些链接是满足我们要求的格式。

总结

这一节主要是学习了scrapy的Spiders类,着重学习了scrapy.Spider和scrapy.CrawlSpider两个类,这两个也是我们用的频度比较高的两个类,这两个需要我们重点的掌握,其他的几个这里并没有详细的解释,有兴趣的可以去查阅scrapy官方文档,或者在以后需要的时候去查阅也可以。