作者:finallyliuyu(注意:转载请标明作者和出处)

题记:

做研究,尤其是基于统计学方法的研究,常常需要大量的训练数据。详细这些东西在读研究生不难得到。在自然语言处理公司工作的工作人员也不难得到。但是这些东西属于机密,实验室和公司是不会轻易外传的。所以对于业余的爱好者来说,比如园子里的(蛙蛙,overred)是很难得到详实的语料库的。目前中文文本分类语料库只有搜狗实验室一家对广大网友开放了,见:http://www.sogou.com/labs/dl/c.html。笔者在实验中用过它提供的完整版(107M)的语料库。确实还是不错的,分为汽车,财经,IT,健康,体育,旅游,教育,招聘,文化,军事 10个类别,每个类别有8000篇新闻,每篇新闻大概是100-300个字左右,属于短新闻。

在这里首先要对搜狗实验室的无私奉献表示感谢。我所提供的语料库自然不如搜狗实验室提供的语料库那么标准和整洁,毕竟人家是有人工整理的,我的是用新闻爬虫直接从网络上爬取的。我可以保证我所提供的语料库大部分新闻文本纯度比较高,但是不排除有一部分新闻只有标题,没有正文,而获正文里面掺杂了很多其他语义不相关的内容(如广告等)。下面说一下我的语料库和搜狗实验室提供的语料库(以下简称搜狗语料库)相比有何特点吧。

1。 长新闻比较多,新闻语义内容丰富:有很多评论新闻高达几千字

2。拥有新闻标题:搜狗语料库的新闻标题统一用数字表示,而我的语料库中的新闻都有自己的标题,这可以帮助研究者从语义的直观感觉上上判断各种分类算法的效果。抽象的准确率和召回率等数学指标,常常使研究者不能具体地感受到分类或聚类算法的巨大威力与魅力。

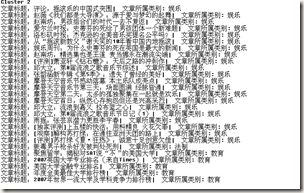

这里上个图:(看到了新闻的标题,我们就很容易评判聚类是否准确了)

下面介绍下:语料库的情况。

新闻正文提取所用到网页正文提取的算法见《驴子的新闻采阅系统》此系列博文中所讲的算法为我大学本科毕业设计中所实现的算法。此语料库搜集时间为2009年12月-2010年1月。是我在中科院自动化所读研一期间利用业余时间搜集的。当时为了完成王斌老师的《现代信息检索》课程的项目大作业,我将本科毕设的算法又做了进一步的改进,写了一个集成爬虫,正文提取算法,分类器为一体的大型程序。鉴于爬虫破坏力,遂不提供源代码给网友。

语料资源来源:腾讯新闻,凤凰新闻,新浪新闻,网易新闻

语料库存储在MSSQLServer2000数据库中。存储字段等视图如下

下面给出语料库内部的一些统计信息

类别: history, culture,reading,miltary, it, society$law, entertaiment, education

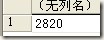

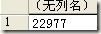

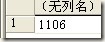

各个类别的文章篇数:

select count(*)from News where Categorization='history'

ArticleId 分布范围 1-1905

select count(*)from News where Categorization='culture'

ArticleId分布范围 1906-4725

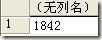

select count(*)from News where Categorization='reading'

ArticleId分布范围4726-12860

select count(*)from News where Categorization='military'

ArticleId分布范围12861-14702

select count(*)from News where Categorization='it'

ArticleId分布范围14703-15064

select count(*)from News where Categorization='society&law'

ArticleId分布范围15065-38041

select count(*)from News where Categorization='entertainment'

ArticleId分布范围 38042-39147

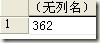

select count(*)from News where Categorization='education'

ArticleId分布范围39148-39247

从上面的数据我们可以看出,我的语料库分布“不平衡”,“不标准”。但我认为这样它更接近实际生活中的问题。接下来的时间里我将利用我自己的分类语料库来验证各种分类算法以及聚类算法的效果,和 牛人论文中的实验数据进行对比(主:论文中给出的准确率召回率等指标都是在标准的分类语料库上运行得出的),所以我想我的验证更有实践意义。

在本系列博文写完后,

我将提供特征预处理代码供大家下载 目前部分预处理代码下载地址见《Kmeans系列》其中只实现了DF 特征选择方法,接下来我会实现 IG,卡方等方法,并且也会次采用多种TF-IDF模式实现VSM模型,敬请大家关注我的博客。

语料库大小160M最后备份压缩到54.8M,感谢DUDU在博客园帮忙提供空间也感谢博客园团队。中心祝愿你们越办越好!

(今天太晚了,我得先回家,明天上传后,会在第一时间将地址通知给大家)

语料库搜集整理者:刘禹

工作单位:中科院自动化所综合信息中心

语料库下载及出处地址:博客园(空间提供方)