1.词法分析

词是自然语言中能够独立运用的最小单位,是自然语言处理的基本单位。词法分析就是利用计算机对自然语言的形态 (morphology) 进行分析,判断词的结构和类别等。

词法分析的主要任务是:①:能正确的把一串连续的字符切分成一个一个的词 ②:能正确地判断每个词的词性,以便于后续的句法分析的实现。

常见的中文分词算法:(分为三类,1.基于字符串匹配(机械分词)的分词方法、2.基于理解的分词方法、3.基于统计的分词方法)

最大匹配法(正向、逆向) 1基于字符串匹配

基于词典的中文分词 1基于字符串匹配

基于标记法

约束矩阵法

句模切分法

神经网络分析算法 2.基于理解

基于统计语言模型(共现率) 3.基于统计

专家系统分词算法

常见分词项目:

word分词

FudanNLP

Paoding

MMSEG4J

jcseg

ICTCLAS

智呈分词

MFSOU分词

SCWS

jieba

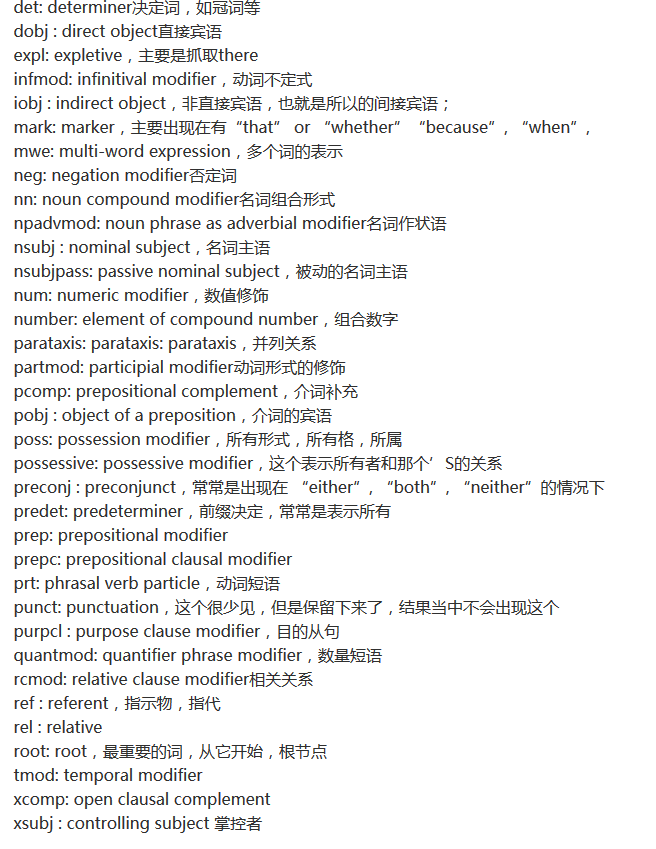

2.句法分析(语法分析)

运用自然语言的句法和其他知识来确定组成输入句各成分功能。对句子中的词语语法功能进行分析。(每个词充当的角色,主语、谓语等)。

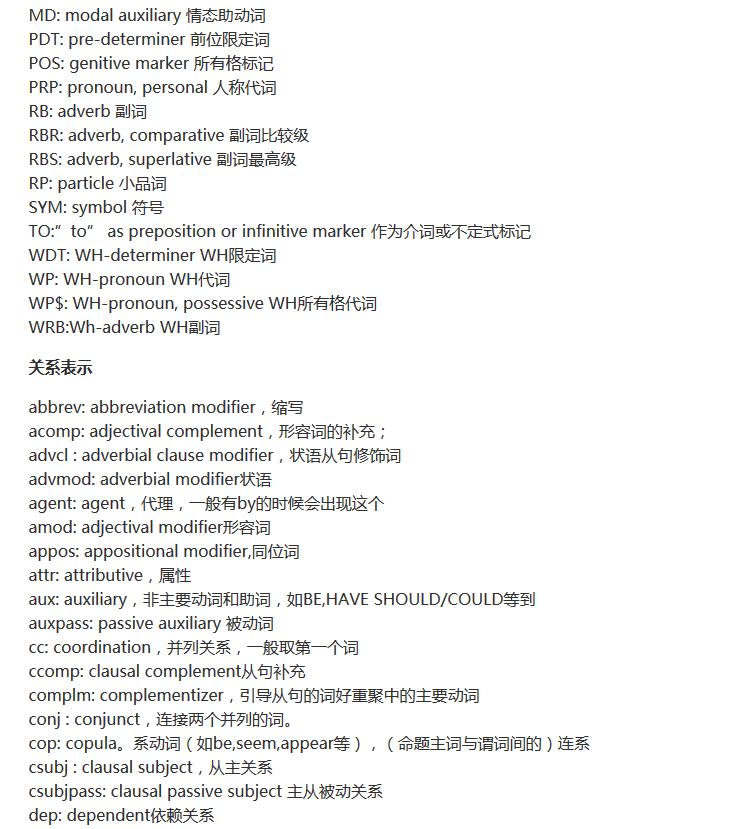

句法分析的基本任务是:确定句子的语法结构或句子中词汇之间的依存关系。

句法分析分为:句法结构分析和依存关系分析两种。

采用语法树来表示

3.语义分析

4.语用分析

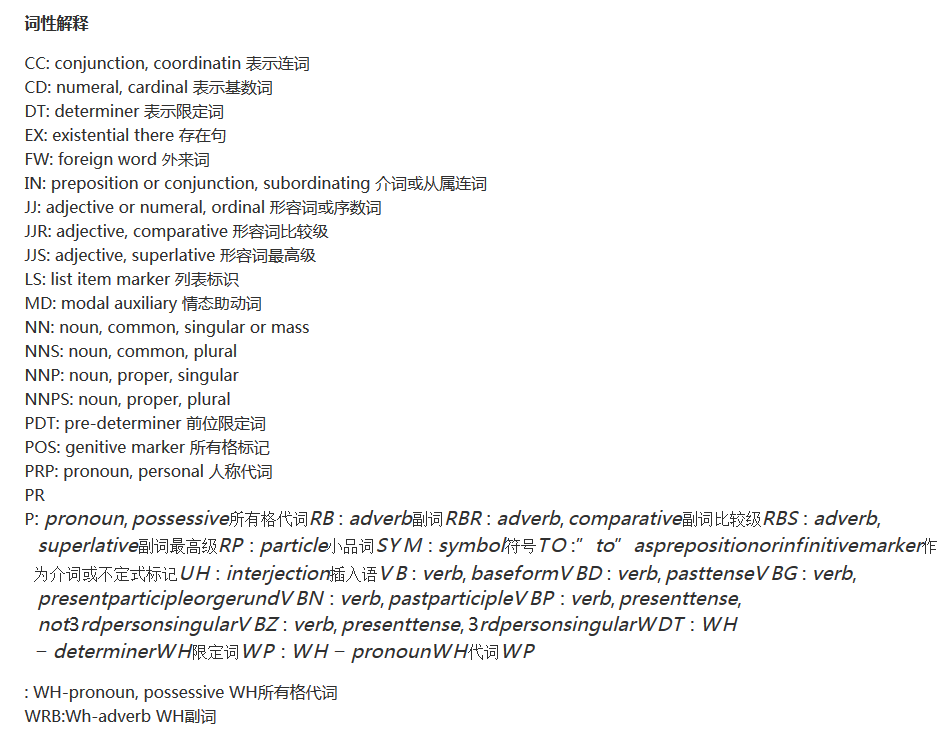

5.常见的术语:

未登录词:命名实体(人名、地名)、新词,专业术语称为未登录词。也就是那些在分词词典中没有收录,但又确实能称为词的那些词。