摘要:

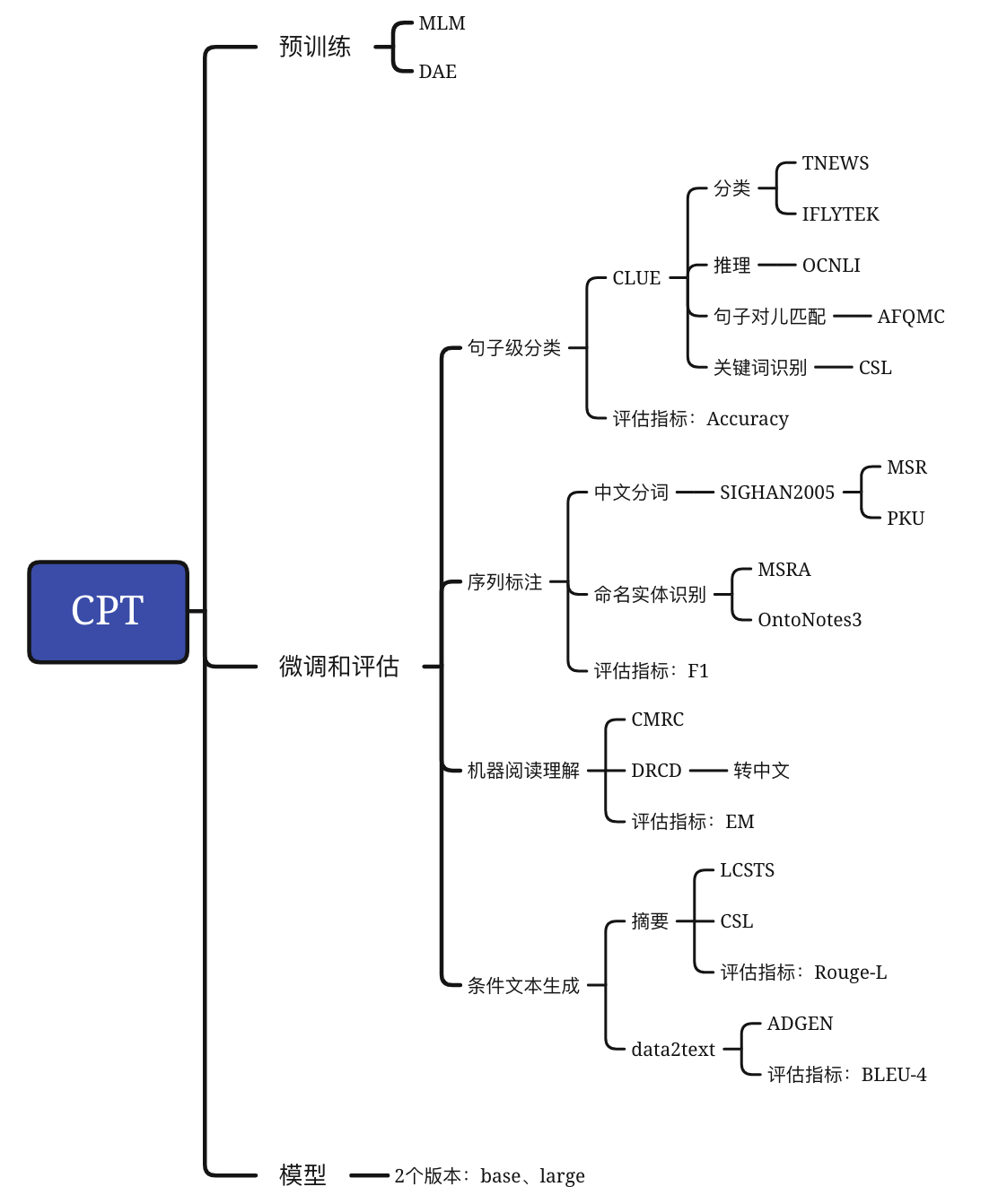

微调任务

CPT: A Pre-Trained Unbalanced Transformer for Both Chinese Language Understanding and Generation

复旦大学,邱锡鹏老师团队

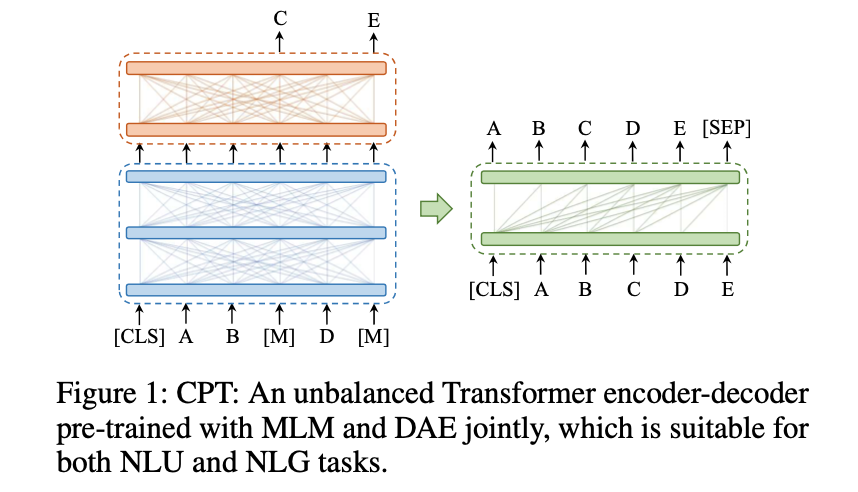

使用不平衡的Transformer编码器解码器架构,用MLM和DAE联合预训练,均可用于NLU和NLG。

CPT: a novel Chinese Pre-trained Unbalanced Transformer for both NLU and NLG tasks.

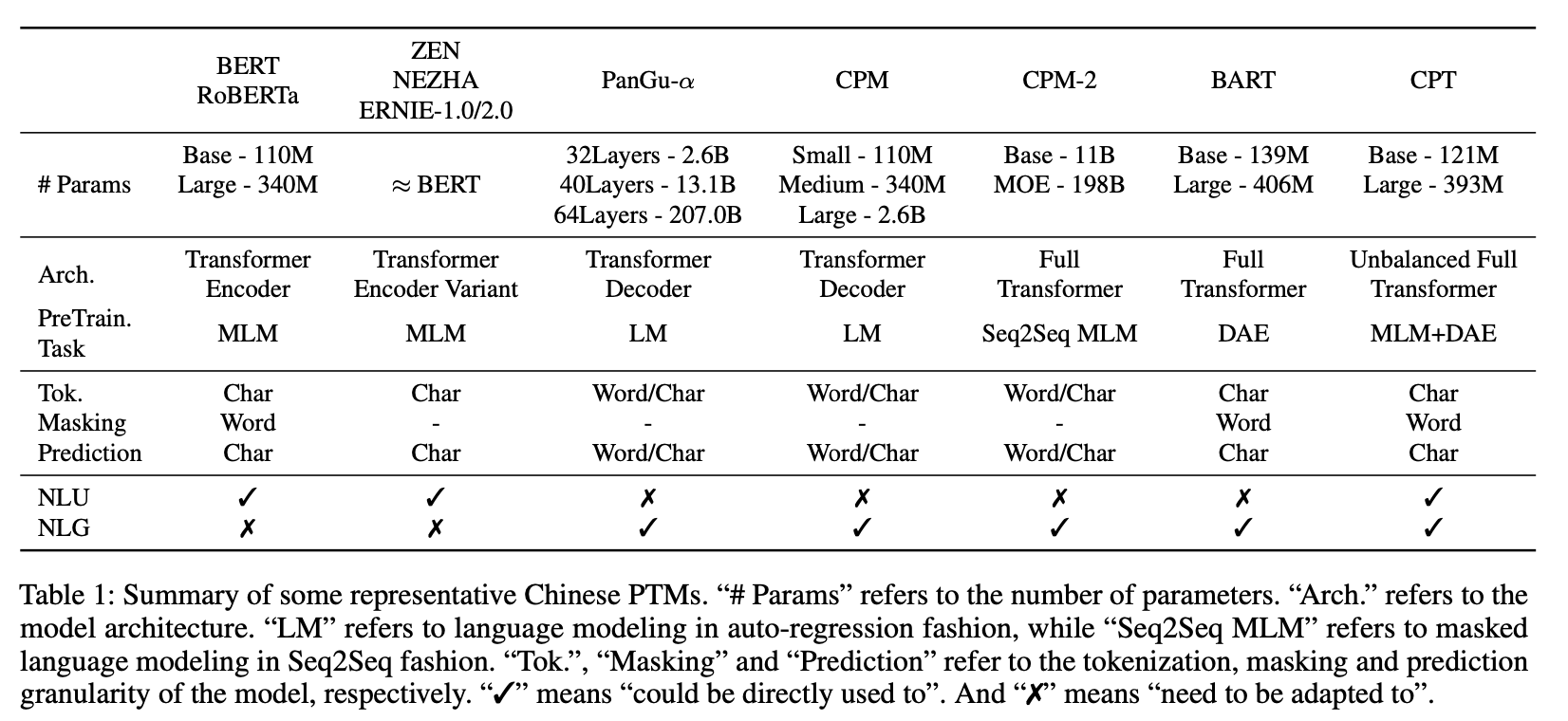

BERT、RoBERTa、ZEN、NEZHA、ERNIE-1.0/2.0可以文本理解,但是不能文本生成;

PanGu-α、CPM、CPM-2、BART可以文本生成,但是不能文本理解;

CPT既可以文本理解,又可以文本生成。

微调的任务