一、配置core-site.xml

/usr/local/hadoop/etc/hadoop/core-site.xml 包含了hadoop启动时的配置信息。

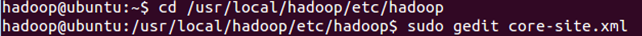

编辑器中打开此文件

sudo gedit /usr/local/hadoop/etc/hadoop/core-site.xml

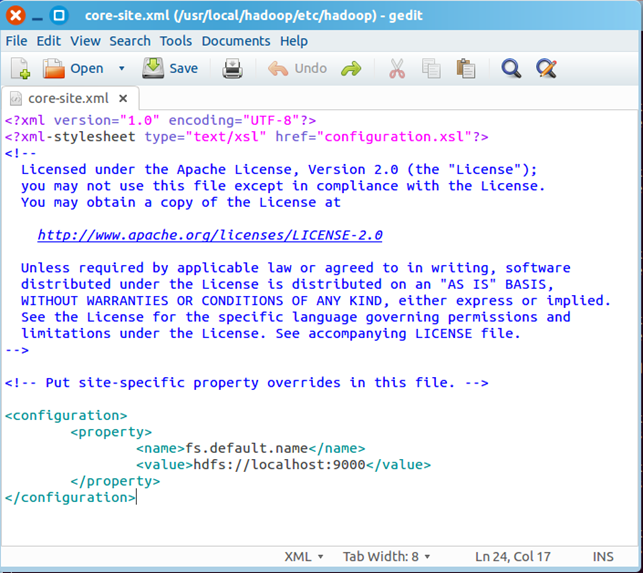

在该文件的<configuration></configuration>之间增加如下内容:

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

保存、关闭编辑窗口。

最终修改后的文件内容如下:

二、配置yarn-site.xml

/usr/local/hadoop/etc/hadoop/yarn-site.xml包含了MapReduce启动时的配置信息。

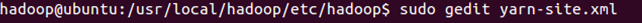

编辑器中打开此文件

sudo gedit yarn-site.xml

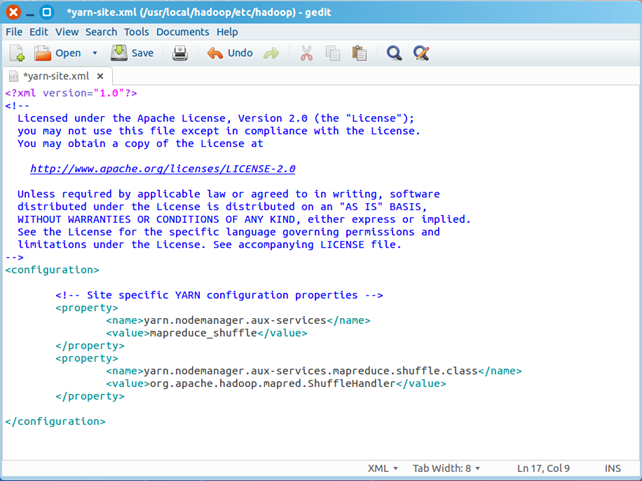

在该文件的<configuration></configuration>之间增加如下内容:

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

保存、关闭编辑窗口

最终修改后的文件内容如下

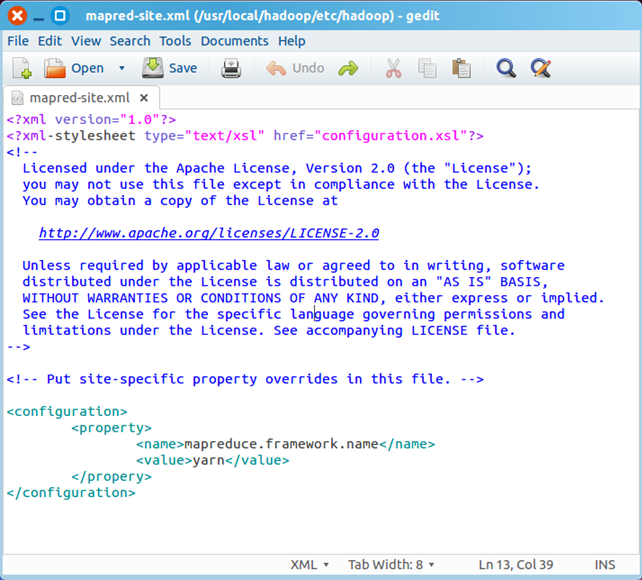

三、创建和配置mapred-site.xml

默认情况下,/usr/local/hadoop/etc/hadoop/文件夹下有mapred.xml.template文件,我们要复制该文件,并命名为mapred.xml,该文件用于指定MapReduce使用的框架。

复制并重命名

cp mapred-site.xml.template mapred-site.xml

编辑器打开此新建文件

sudo gedit mapred-site.xml

在该文件的<configuration></configuration>之间增加如下内容:

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

保存、关闭编辑窗口

最终修改后的文件内容如下

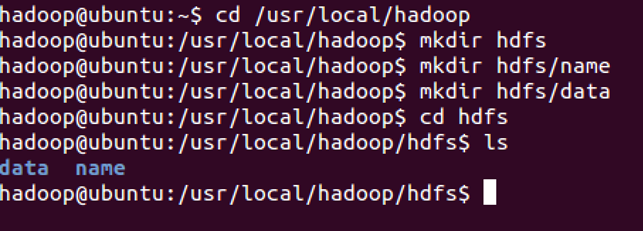

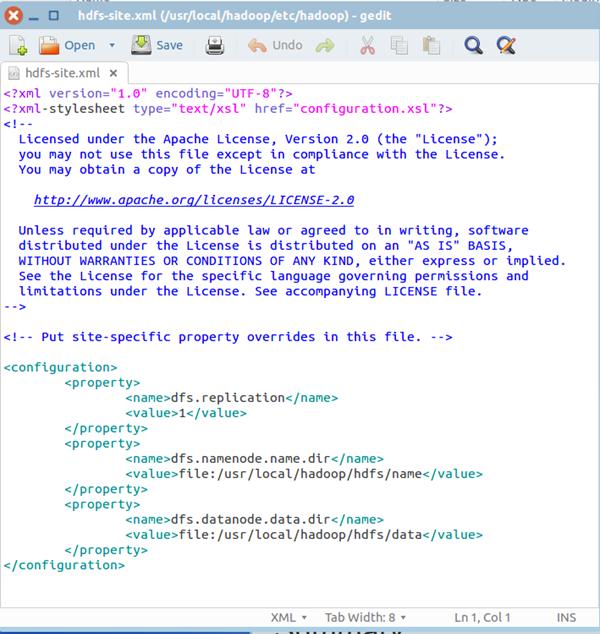

四、配置hdfs-site.xml

/usr/local/hadoop/etc/hadoop/hdfs-site.xml用来配置集群中每台主机都可用,指定主机上作为namenode和datanode的目录。

创建文件夹,如下图所示

你也可以在别的路径下创建上图的文件夹,名称也可以与上图不同,但是需要和hdfs-site.xml中的配置一致。

编辑器打开hdfs-site.xml

在该文件的<configuration></configuration>之间增加如下内容:

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/hdfs/data</value>

</property>

保存、关闭编辑窗口

最终修改后的文件内容如下:

五、格式化hdfs

在profile文件中添加:

export JAVA_LIBRARY_PATH=/usr/local/hadoop/lib/native

(注:调用hadoop里的库)

hdfs namenode -format

只需要执行一次即可,如果在hadoop已经使用后再次执行,会清除掉hdfs上的所有数据。

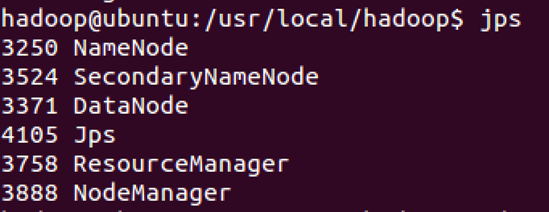

六、启动Hadoop

经过上文所描述配置和操作后,下面就可以启动这个单节点的集群

执行启动命令:

sbin/start-dfs.sh

执行该命令时,如果有yes /no提示,输入yes,回车即可。

接下来,执行:

sbin/start-yarn.sh

执行完这两个命令后,Hadoop会启动并运行

执行 jps命令,会看到Hadoop相关的进程,如下图:

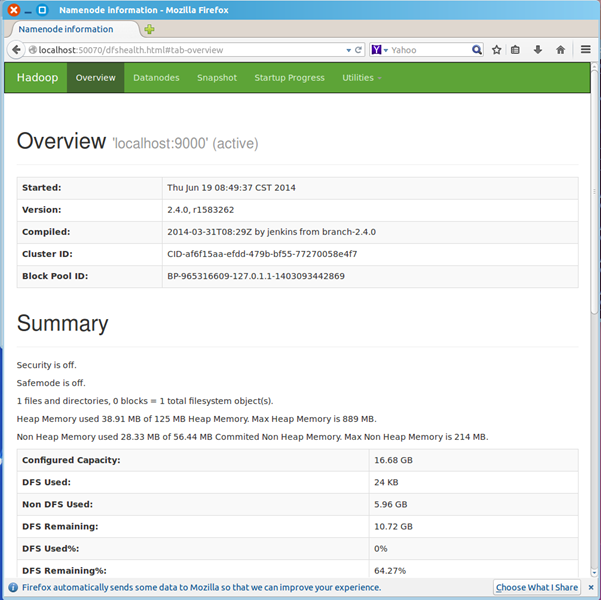

浏览器打开 http://localhost:50070/,会看到hdfs管理页面

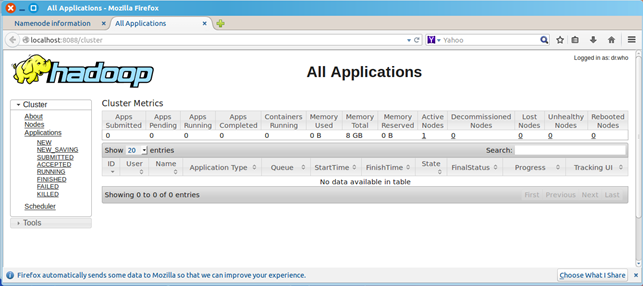

浏览器打开http://localhost:8088,会看到hadoop进程管理页面

七、WordCount验证

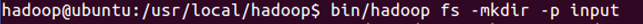

dfs上创建input目录

bin/hadoop fs -mkdir -p input

把hadoop目录下的README.txt拷贝到dfs新建的input里

hadoop fs -copyFromLocal README.txt input

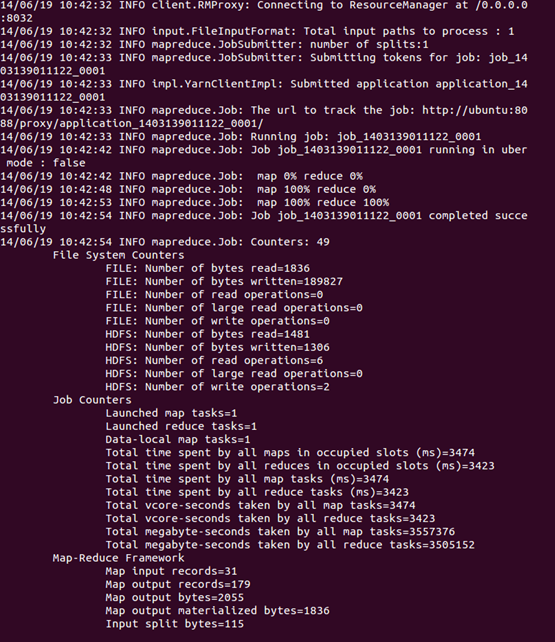

运行WordCount

hadoop jar share/hadoop/mapreduce/sources/hadoop-mapreduce-examples-2.4.0-sources.jar org.apache.hadoop.examples.WordCount input output

可以看到执行过程

运行完毕后,查看单词统计结果

hadoop fs -cat output/*

Python脚本文件中使用中文

String.trim的作用

Ivy入门笔记

Groovy正则表达式复杂逻辑判断实例

Build a ZenTao Server on Linux

Ubuntu上安装gevent

Install Redmine Server with Bitnami Installer

Semi-automation Script Based on Sleep

关于MySQL的事务处理及隔离级别