最近博主遇到这样一个需求:当用户输入一个词语时,返回这个词语的解释

我的第一个想法是做一个数据库,把常用的词语和词语的解释放到数据库里面,当用户查询时直接读取数据库结果

但是自己又没有心思做这样一个数据库,于是就想到了百度百科这么一个现成的 “数据库”

下面我们就通过 urllib 和 xpath 来获取百度百科的内容

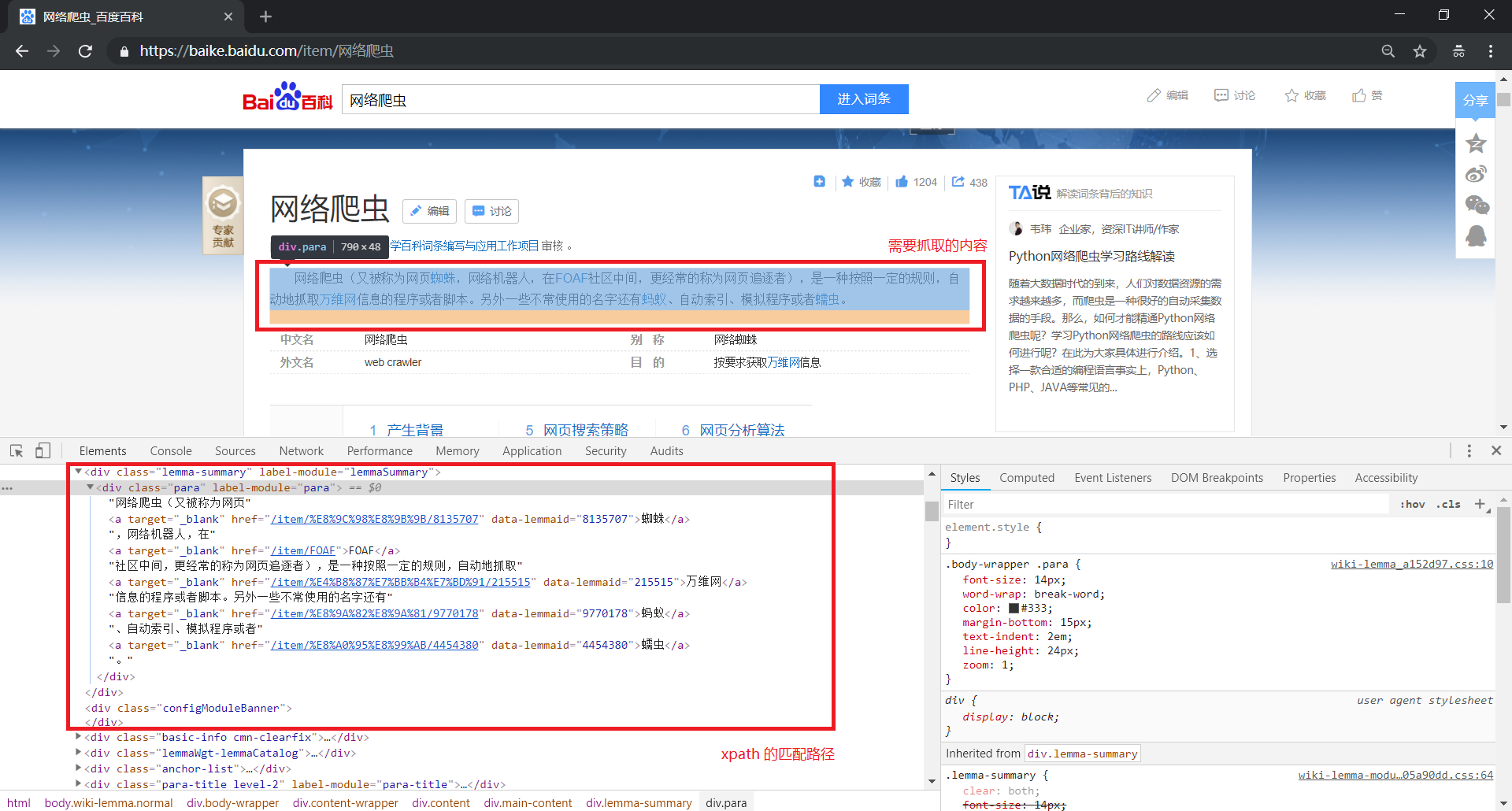

1、爬取百度百科

百度百科是一个静态网页,爬取起来很简单,而且请求参数可以直接放在 URL 里面,例如:

地址 https://baike.baidu.com/item/网络爬虫 对应的就是 网络爬虫 的百度百科页面

地址 https://baike.baidu.com/item/计算机 对应的就是 计算机 的百度百科页面

可以说是十分方便,也不多说,直接放代码,有不明白的地方可以看看注释:

如果对于 urllib 的使用不太清楚,可以参考 爬虫系列(三) urllib的基本使用

如果对于 xpath 的使用不太清楚,可以参考 爬虫系列(九) xpath的基本使用

import urllib.request

import urllib.parse

from lxml import etree

def query(content):

# 请求地址

url = 'https://baike.baidu.com/item/' + urllib.parse.quote(content)

# 请求头部

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.99 Safari/537.36'

}

# 利用请求地址和请求头部构造请求对象

req = urllib.request.Request(url=url, headers=headers, method='GET')

# 发送请求,获得响应

response = urllib.request.urlopen(req)

# 读取响应,获得文本

text = response.read().decode('utf-8')

# 构造 _Element 对象

html = etree.HTML(text)

# 使用 xpath 匹配数据,得到匹配字符串列表

sen_list = html.xpath('//div[contains(@class,"lemma-summary") or contains(@class,"lemmaWgt-lemmaSummary")]//text()')

# 过滤数据,去掉空白

sen_list_after_filter = [item.strip('

') for item in sen_list]

# 将字符串列表连成字符串并返回

return ''.join(sen_list_after_filter)

if __name__ == '__main__':

while (True):

content = input('查询词语:')

result = query(content)

print("查询结果:%s" % result)

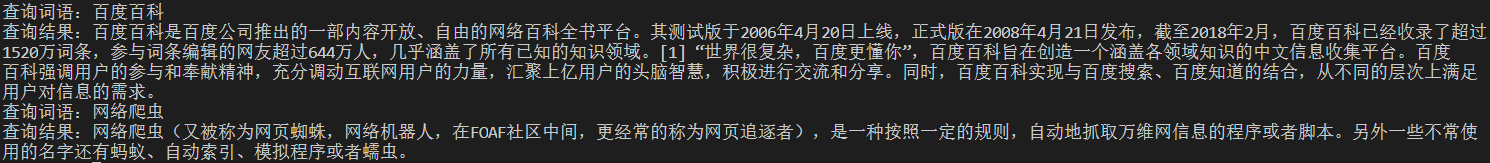

效果演示:

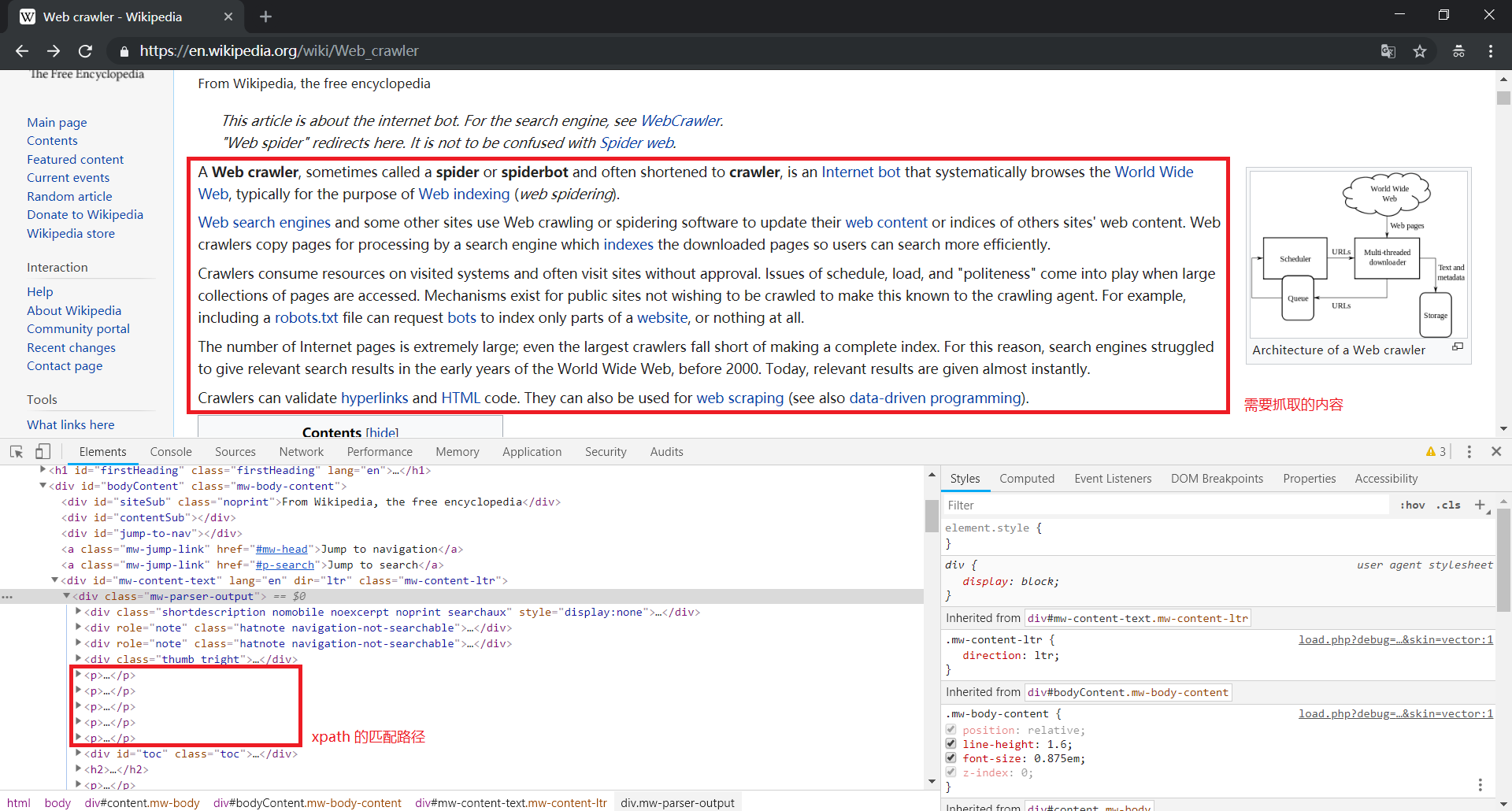

2、爬取维基百科

上面的确是可以解决一些问题,但是如果用户查询为英文怎么办?我们知道,百度百科一般极少收录英文词条

类似的,很容易想到爬取维基百科,思路也和爬取百度百科一样,只需处理一下请求地址和返回结果就好

下面也是直接放上代码,有不明白的地方可以看看注释:

from lxml import etree

import urllib.request

import urllib.parse

def query(content):

# 请求地址

url = 'https://en.wikipedia.org/wiki/' + content

# 请求头部

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.99 Safari/537.36'

}

# 利用请求地址和请求头部构造请求对象

req = urllib.request.Request(url=url, headers=headers, method='GET')

# 发送请求,获得响应

response = urllib.request.urlopen(req)

# 读取响应,获得文本

text = response.read().decode('utf-8')

# 构造 _Element 对象

html = etree.HTML(text)

# 使用 xpath 匹配数据,得到 <div class="mw-parser-output"> 下所有的子节点对象

obj_list = html.xpath('//div[@class="mw-parser-output"]/*')

# 在所有的子节点对象中获取有用的 <p> 节点对象

for i in range(0,len(obj_list)):

if 'p' == obj_list[i].tag:

start = i

break

for i in range(start,len(obj_list)):

if 'p' != obj_list[i].tag:

end = i

break

p_list = obj_list[start:end]

# 使用 xpath 匹配数据,得到 <p> 下所有的文本节点对象

sen_list_list = [obj.xpath('.//text()') for obj in p_list]

# 将文本节点对象转化为字符串列表

sen_list = [sen.encode('utf-8').decode() for sen_list in sen_list_list for sen in sen_list]

# 过滤数据,去掉空白

sen_list_after_filter = [item.strip('

') for item in sen_list]

# 将字符串列表连成字符串并返回

return ''.join(sen_list_after_filter)

if __name__ == '__main__':

while (True):

content = input('Word: ')

result = query(content)

print("Result: %s" % result)

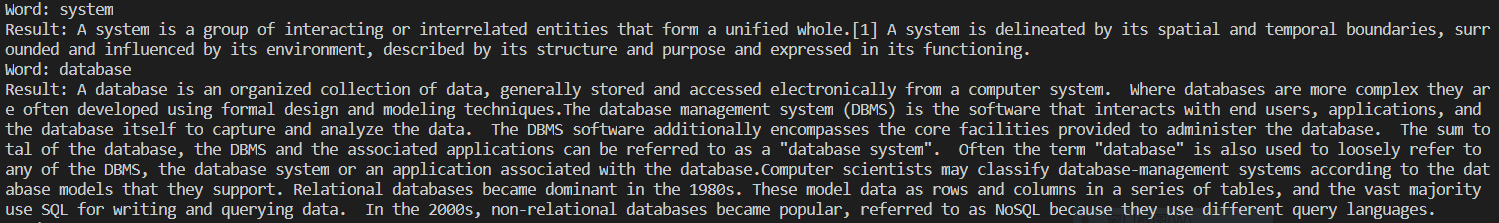

下面是效果演示:

OK,大功告成!

注意:本项目代码仅作学习交流使用!!!