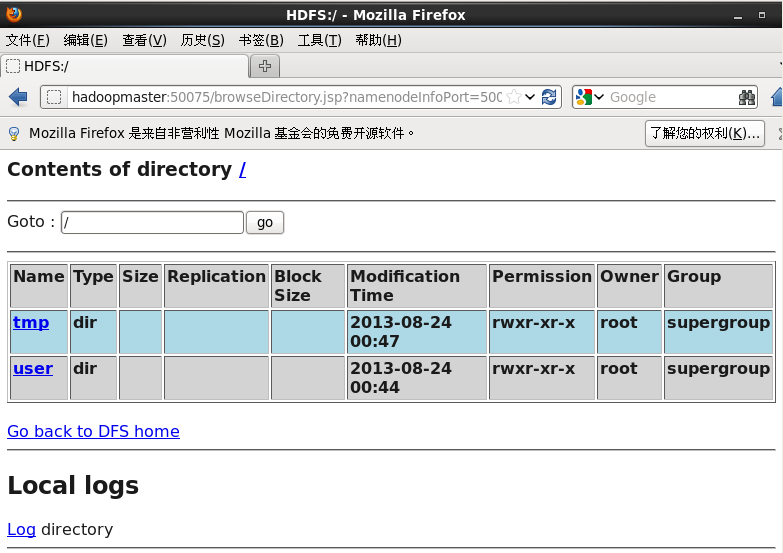

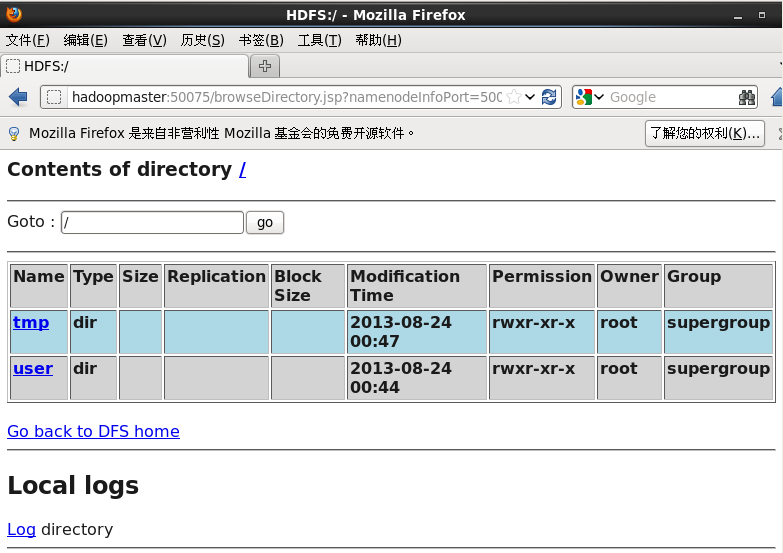

Found 2 items

drwxr-xr-x- root supergroup02013-08-24 00:47/tmp

drwxr-xr-x- root supergroup02013-08-24 00:44/user

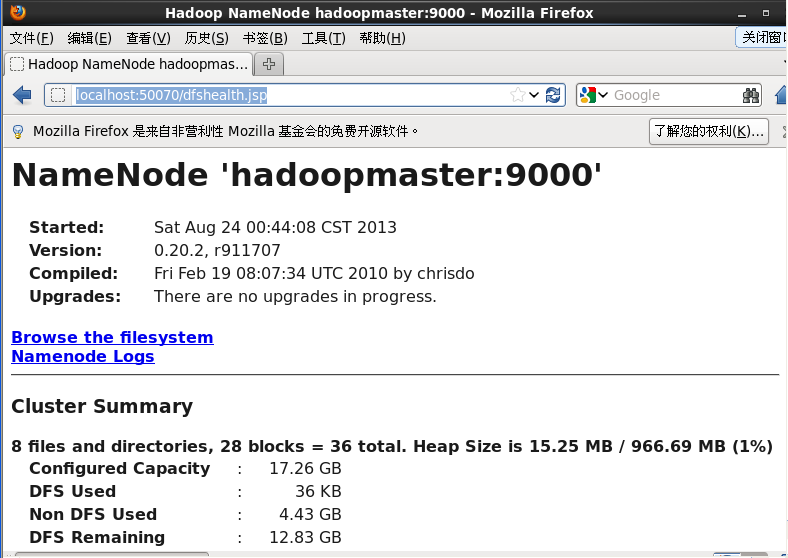

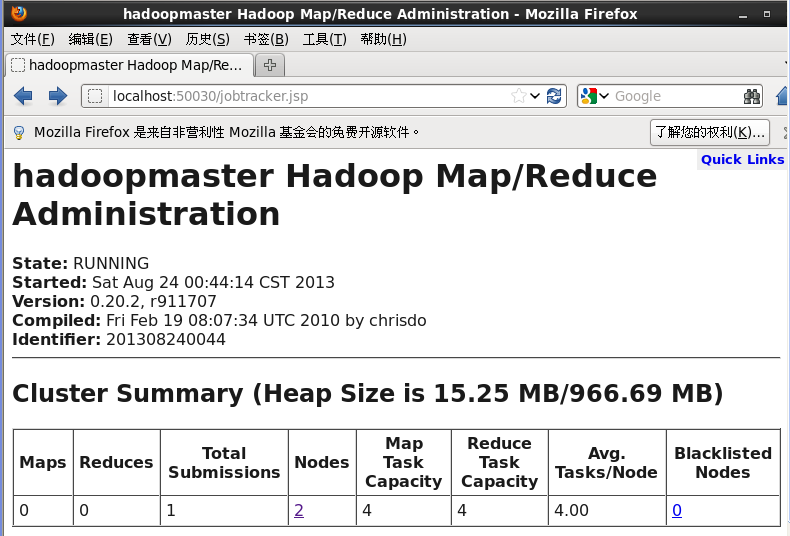

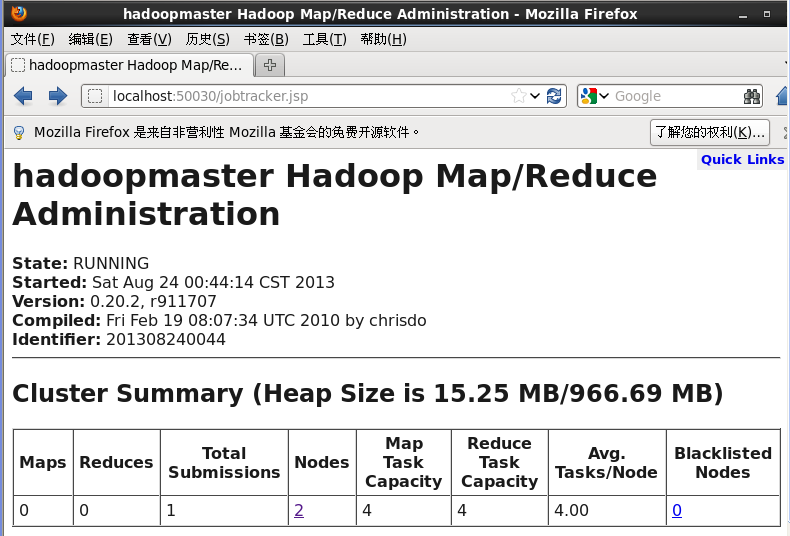

这就是hadoop中的分布式文件系统,即为hdfs,这里我说明了两种查看方式。2、查看任务跟踪jobtracker,即为任务跟踪可以在浏览器中输入localhost:50030

这就是hadoop中的分布式文件系统,即为hdfs,这里我说明了两种查看方式。2、查看任务跟踪jobtracker,即为任务跟踪可以在浏览器中输入localhost:50030

免责声明:文章转载自《hadoop如何查看文件系统》仅用于学习参考。如对内容有疑问,请及时联系本站处理。

上篇微信申请 包名和签名ubuntu创建pycharm快捷方式或不显示图标下篇

宿迁高防,2C2G15M,22元/月;香港BGP,2C5G5M,25元/月 雨云优惠码:MjYwNzM=

一、准备工作 1.准备几台机器,我这里使用VMware准备了四台机器,一个name node,三个data node。 VMware安装虚拟机:https://www.cnblogs.com/nijunyang/p/12001312.html 2.Hadoop生态几乎都是用的java开发的,因此四台机器还需要安装JDK。 3.集群内主机域名...

配置文件都在:/etc/服务名, 看hadoop的classpath |grep conf /etc/hadoop/conf log都在: /var/log/服务名 看scm的log: tail -1000 /var/log/cloudera-scm-server/cloudera-scm-server.log |grep error hive: /...

小文件指的是那些size比HDFS的block size(默认64M)小的多的文件。不论什么一个文件,文件夹和block,在HDFS中都会被表示为一个object存储在namenode的内存中, 每一个object占用150 bytes的内存空间。 所以,假设有10million个文件, 每一个文件相应一个block,那么就将要消耗namenode 3G...

1: 关闭防火墙(Centos6.5).集群中每台机器都要关闭 //临时关闭 service iptables stop //禁止开机启动 chkconfig iptables off 2.hostname 修改. vim /etc/sysconfig/networkvim /etc/hostssysctl kernel.hostname 或者 hostn...

写在前面 生产上的spark一般来说都是需要我们自己手动编译的,编译适合自己公司生产环境上的spark版本。参照官网http://spark.apache.org/docs/latest/building-spark.html 前置:使用Maven构建Spark需要Maven 3.5.4和Java 8. Spark 源码编译 首先调大CacheSi...

1.安装ambari-server yum -y install ambari-server 2.ambariserver需要一个数据库存储元数据,默认使用的 Postgres数据库。默认的用户名和密码是:ambari/bigdata 。但是一般情况下,后面还要安装 hive和 Ranger,也需要一个存元数据的数据库,所以使用一个mysql做为数据库。需...